विषय

- बिग डेटा अनस्ट्रक्चर्ड या सेमी-स्ट्रक्चर्ड है

- अगर हम इसे संसाधित नहीं कर सकते तो बड़े डेटा को संग्रहीत करने में कोई बिंदु नहीं है

- कैसे Hadoop बिग डेटा समस्या हल करता है

- Hadoop के लिए व्यावसायिक मामला

ले जाओ:

Hadoop कुछ बड़े डेटा बड़ी चुनौतियों को हल करने में मदद कर सकता है।

बड़ा डेटा है ... अच्छा ... आकार में बड़ा! वास्तव में कितने डेटा को बड़े डेटा के रूप में वर्गीकृत किया जा सकता है, बहुत स्पष्ट कटौती नहीं है, इसलिए उस बहस में फंसने नहीं देता। गीगाबाइट में डेटा से निपटने के लिए उपयोग की जाने वाली छोटी कंपनी के लिए, 10 टीबी डेटा बीआईजी होगा। हालाँकि और याहू जैसी कंपनियों के लिए, पेटाबाइट्स बड़ा है।बस बड़े डेटा का आकार, डेटाबेस या पारंपरिक फाइलरों जैसे पारंपरिक भंडारण में इसे स्टोर करना असंभव (या कम से कम लागत निषेधात्मक) बनाता है। हम गीगाबाइट डेटा स्टोर करने के लिए लागत के बारे में बात कर रहे हैं। पारंपरिक स्टोरेज फाइलरों का उपयोग करने से बड़ा डेटा स्टोर करने में बहुत पैसा खर्च हो सकता है।

यहाँ अच्छी तरह से बड़े डेटा, इसकी चुनौतियों और कैसे Hadoop उन्हें हल करने में मदद कर सकते हैं पर एक नज़र रखना।सबसे पहले, बड़े डेटा सबसे बड़ी चुनौतियां।

बिग डेटा अनस्ट्रक्चर्ड या सेमी-स्ट्रक्चर्ड है

बहुत बड़ा डेटा अनस्ट्रक्चर्ड है। उदाहरण के लिए, क्लिक करें स्ट्रीम लॉग डेटा जैसा दिख सकता है:समय टिकट, user_id, पृष्ठ, संदर्भ_पृष्ठ

संरचना का अभाव संबंधपरक डेटाबेस को बड़े डेटा को स्टोर करने के लिए अच्छी तरह से अनुकूल नहीं बनाता है। इसके अलावा, कई डेटाबेस डेटा की अरबों पंक्तियों को संग्रहीत करने का सामना नहीं कर सकते हैं।

अगर हम इसे संसाधित नहीं कर सकते तो बड़े डेटा को संग्रहीत करने में कोई बिंदु नहीं है

बड़ा डेटा स्टोर करना खेल का हिस्सा है। हमें इसे बुद्धि से बाहर निकालने के लिए संसाधित करना होगा। पारंपरिक भंडारण प्रणाली इस अर्थ में "गूंगा" है कि वे सिर्फ बिट्स स्टोर करते हैं। वे किसी भी प्रसंस्करण शक्ति की पेशकश नहीं करते हैं।पारंपरिक डेटा प्रोसेसिंग मॉडल में स्टोरेज क्लस्टर में संग्रहीत डेटा होता है, जिसे प्रोसेसिंग के लिए एक कम्प्यूट क्लस्टर पर कॉपी किया जाता है। परिणाम संग्रहण क्लस्टर पर वापस लिखे गए हैं।

यह मॉडल, हालांकि, बड़े डेटा के लिए काफी काम नहीं करता है क्योंकि एक गणना क्लस्टर के लिए बहुत अधिक डेटा कॉपी करना बहुत अधिक समय लेने या असंभव हो सकता है। तो उत्तर क्या है?

एक समाधान जगह में बड़े डेटा को संसाधित करना है, जैसे कि एक संग्रहण क्लस्टर में एक गणना क्लस्टर के रूप में दोहरीकरण।

जैसा कि हमने ऊपर देखा है, बड़ा डेटा पारंपरिक भंडारण को परिभाषित करता है। तो हम बड़े डेटा को कैसे संभालते हैं?

कैसे Hadoop बिग डेटा समस्या हल करता है

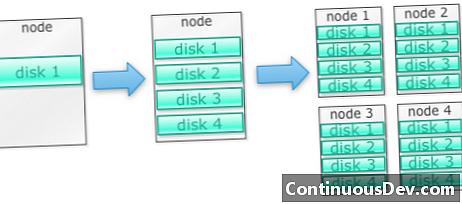

Hadoop को मशीनों के एक समूह पर चलाने के लिए बनाया गया हैएक उदाहरण से शुरू करते हैं। आइए हम बताते हैं कि हमें बहुत सी तस्वीरों को संग्रहीत करने की आवश्यकता है। हम एक डिस्क से शुरू करेंगे। जब हम एकल डिस्क को पार करते हैं, तो हम मशीन पर स्टैक्ड कुछ डिस्क का उपयोग कर सकते हैं। जब हम एक मशीन पर सभी डिस्क को अधिकतम करते हैं, तो हमें मशीनों का एक गुच्छा, प्रत्येक डिस्क के एक गुच्छा के साथ प्राप्त करने की आवश्यकता होती है।

यह ठीक उसी प्रकार है जैसे हाडोप बनाया गया है। Hadoop मशीनों के एक समूह पर चलने के लिए डिज़ाइन किया गया है।

Hadoop क्लस्टर पैमाने क्षैतिज रूप से

Hadoop क्लस्टर में अधिक नोड्स जोड़कर अधिक संग्रहण और गणना शक्ति प्राप्त की जा सकती है। यह अधिक से अधिक शक्तिशाली और महंगे हार्डवेयर खरीदने की आवश्यकता को समाप्त करता है।

Hadoop असंरचित / अर्ध-संरचित डेटा को संभाल सकता है

Hadoop doesn t इसे स्टोर करने वाले डेटा पर एक स्कीमा लागू करता है। यह मनमाना और द्विआधारी डेटा को संभाल सकता है। तो Hadoop किसी भी असंरचित डेटा को आसानी से पचा सकता है।

Hadoop क्लस्टर भंडारण और कंप्यूटिंग प्रदान करता है

हमने देखा कि कैसे अलग-अलग स्टोरेज और प्रोसेसिंग क्लस्टर रखना बड़े डेटा के लिए सबसे उपयुक्त नहीं है। Hadoop क्लस्टर, हालांकि, भंडारण प्रदान करते हैं और सभी को एक में वितरित करते हैं।

Hadoop के लिए व्यावसायिक मामला

Hadoop उचित लागत पर बड़े डेटा के लिए भंडारण प्रदान करता है

पारंपरिक भंडारण का उपयोग कर बड़ा डेटा संग्रहीत करना महंगा हो सकता है। Hadoop कमोडिटी हार्डवेयर के आसपास बनाया गया है, इसलिए यह उचित लागत के लिए काफी बड़ा भंडारण प्रदान कर सकता है। Hadoop को पेटाबाइट स्केल में क्षेत्र में उपयोग किया गया है।

क्लोदेरा के एक अध्ययन ने सुझाव दिया है कि उद्यम आमतौर पर प्रति वर्ष $ 25,000 से $ 50,000 प्रति टेराबाइट खर्च करते हैं। Hadoop के साथ, यह लागत कुछ हजार डॉलर प्रति टेराबाइट प्रति वर्ष हो जाती है। जैसे-जैसे हार्डवेयर सस्ता और सस्ता होता जाता है, यह लागत कम होती जाती है।

Hadoop नए या अधिक डेटा को कैप्चर करने की अनुमति देता है

कभी-कभी संगठन डेटा के एक प्रकार पर कब्जा नहीं करते हैं क्योंकि इसे स्टोर करने के लिए बहुत अधिक लागत निषेधात्मक था। चूंकि Hadoop उचित लागत पर भंडारण प्रदान करता है, इसलिए इस प्रकार के डेटा को कैप्चर और संग्रहीत किया जा सकता है।

एक उदाहरण वेबसाइट क्लिक लॉग होगा। क्योंकि इन लॉग की मात्रा बहुत अधिक हो सकती है, न कि कई संगठनों ने इन पर कब्जा कर लिया है। अब Hadoop के साथ लॉग को कैप्चर करना और स्टोर करना संभव है।

Hadoop के साथ, आप डेटा को अधिक समय तक स्टोर कर सकते हैं

संग्रहीत डेटा की मात्रा का प्रबंधन करने के लिए, कंपनियां समय-समय पर पुराने डेटा को शुद्ध करती हैं। उदाहरण के लिए, केवल पिछले तीन महीनों के लॉग को संग्रहीत किया जा सकता है, जबकि पुराने लॉग हटा दिए गए थे। Hadoop के साथ ऐतिहासिक डेटा को लंबे समय तक संग्रहीत करना संभव है। यह नए एनालिटिक्स को पुराने ऐतिहासिक डेटा पर करने की अनुमति देता है।

उदाहरण के लिए, किसी वेबसाइट से लॉग पर क्लिक करें। कुछ साल पहले, इन लॉग को कुछ समय के लिए लोकप्रिय पृष्ठों जैसे आँकड़ों की गणना के लिए संग्रहीत किया गया था। अब Hadoop के साथ, लंबे समय तक इन क्लिक लॉग को स्टोर करना व्यवहार्य है।

Hadoop स्केलेबल एनालिटिक्स प्रदान करता है

यह सब डेटा संग्रहीत करने का कोई मतलब नहीं है अगर हम उनका विश्लेषण नहीं कर सकते हैं। Hadoop न केवल वितरित भंडारण प्रदान करता है, बल्कि प्रसंस्करण भी वितरित करता है, जिसका अर्थ है कि हम समानांतर में बड़ी मात्रा में डेटा को क्रंच कर सकते हैं। Hadoop के कम्प्यूट फ्रेमवर्क को MapReduce कहा जाता है। MapReduce को पेटाबाइट्स के पैमाने पर सिद्ध किया गया है।

Hadoop समृद्ध विश्लेषिकी प्रदान करता है

Native MapReduce एक प्राथमिक प्रोग्रामिंग भाषा के रूप में जावा का समर्थन करता है। रूबी, पायथन और आर जैसी अन्य भाषाओं का भी उपयोग किया जा सकता है।

बेशक, कस्टम MapReduce कोड लिखना केवल Hadoop में डेटा का विश्लेषण करने का तरीका नहीं है। उच्च-स्तरीय मैप रिड्यूस उपलब्ध है। उदाहरण के लिए, Pig नाम का टूल डेटा फ्लो लैंग्वेज की तरह इंग्लिश लेता है और उन्हें MapReduce में ट्रांसलेट करता है। एक अन्य उपकरण, Hive, SQL क्वेरी लेता है और MapReduce का उपयोग करके उन्हें चलाता है।

व्यावसायिक खुफिया (बीआई) उपकरण उच्च स्तर के विश्लेषण प्रदान कर सकते हैं। इस तरह के विश्लेषण के लिए उपकरण भी हैं।

यह सामग्री मार्क केज़नर और सुजी मनियाम द्वारा "हडोप इल्युमिनेटेड" से ली गई है। इसे क्रिएटिव कॉमन्स एट्रिब्यूशन-नॉन-कॉमर्शियल-शेयरअलाइल 3.0 अनपोर्टेड लाइसेंस के माध्यम से उपलब्ध कराया गया है।